МОСКВА, 6 апр — РИА Новости, Захар Андреев. Искусственный интеллект может выйти из-под контроля. Этого боятся и неспециалисты, и руководители ведущих технологических компаний. Какие угрозы создает развитие нейросетей и как им противостоять — в материале РИА Новости.

Россияне и восстание машин

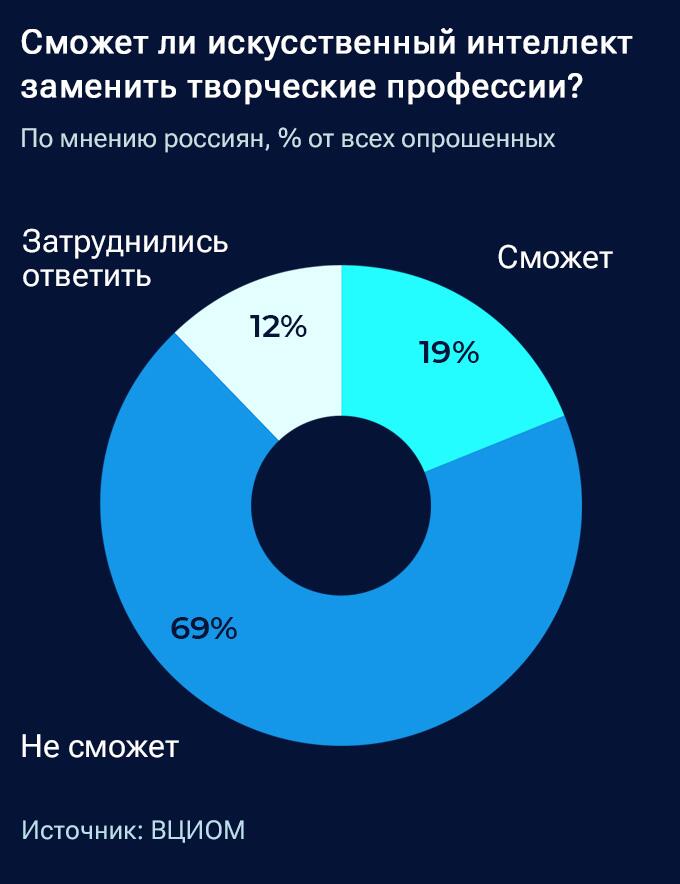

При этом люди, которые, по собственным оценкам, разбираются в нейросетях, допускают возникновение проблем на рынке труда. С тем, что ИИ способен заменить представителей творческих профессий, согласны 37 процентов респондентов. А среди тех, кто ничего о нейросетях не знает, в это верят десять процентов.

Недавний опрос, проведенный порталом Superjob, показал, что развития искусственного интеллекта боятся всего 17 процентов экономически активных взрослых россиян, а 43 процента такая перспектива не пугает. Затруднились ответить 40 процентов респондентов.

"Потеря контроля над цивилизацией"

Страхи обоснованны — по крайней мере, по мнению экономистов и лидеров ведущих мировых технологических компаний. В конце марта американский банк Goldman Sachs выпустил отчет, согласно которому искусственный интеллект, а также основанные на нем сервисы и приложения приведут к сокращению 300 миллионов рабочих мест по всему миру. В зоне риска — профессии, связанные с бухгалтерией, административной и офисной работой. Те, кто занят физическим трудом (например, уборщики и сантехники), пострадают не сильно.

Но экспертов по компьютерным технологиям куда больше пугает вероятность того, что ИИ выйдет из-под контроля. Гендиректор SpaceX, Tesla и Twitter Илон Маск, сооснователь Apple Стив Возняк, визионер Юваль Ной Харари и еще тысяча влиятельных представителей IT-индустрии подписали письмо с просьбой приостановить по меньшей мере на полгода разработку систем мощнее GPT-4, чтобы подготовить протоколы безопасности.

"Должны ли мы развивать нечеловеческий разум, который в конечном итоге может превзойти, перехитрить нас, сделать устаревшими и заменить? Должны ли мы рисковать потерей контроля над нашей цивилизацией? Такие решения нельзя делегировать неизбранным техническим лидерам. Мощные системы ИИ следует разрабатывать только тогда, когда мы уверены, что эффект будет положительным, а риски — управляемыми", — говорится в письме.

Умный, но не самостоятельный

GPT — это чат-бот, разработанный американской компанией OpenAI. Он способен выполнять задания, ранее недоступные для подобных систем: от создания художественных произведений до программирования.

"Сегодня на базе GPT производят и выводят на рынок уникальные сервисы, начиная с персонального ИИ-советника в области инвестиций и заканчивая решениями, помогающими врачам установить правильный диагноз и подобрать оптимальное лечение", — отмечает профессор Высшей школы бизнеса НИУ ВШЭ, руководитель департамента бизнес-информатики Евгений Зараменских.

Известны случаи, когда возможности ChatGPT использовали в сомнительных или откровенно незаконных целях. Чат-бот сдавал экзамены в вузах (как в медицинских, так и по программе MBA), генерировал ключи для активации лицензионных программ, помогал выиграть в лотерее. А в Бельгии мужчина покончил с собой — якобы после месяца общения с чат-ботом, созданным на основе GPT.

В марте вышла четвертая — последняя на сегодня — версия программы. Исследования показали, что у нее уже сейчас проявляются "искры разума". Несмотря на это, до самостоятельного мышления чат-боту пока далеко.

Руководитель IT-направления в Московском городском открытом колледже Даниил Макеев объясняет: есть три типа искусственного интеллекта. Все существующие относятся к ANI — узкому ИИ, направленному на выполнение определенных заданий. Следующая стадия — AGI, общий искусственный интеллект, или, как его еще называют, сильный ИИ. Он сможет решать любые задачи, доступные человеческому интеллекту. Логическим продолжением этой системы должен стать ASI — суперинтеллект, который, по словам эксперта, пока относится к области научной фантастики.

"Может показаться, что нейросеть ChatGPT — это и есть тот самый ИИ, способный развить эмпатию, научиться думать, как человек, и действовать самостоятельно. Но это не так, — подчеркивает Макеев. — Несмотря на то что нейросеть успешно проходит тесты на профессии и понимает юмор, это еще не AGI. ChatGPT не в состоянии улучшать себя и развиваться без помощи людей. И самое главное: нейросеть не умеет мыслить независимо".

Но инженеры работают над тем, чтобы это исправить. Так, один из разработчиков OpenAI Сики Чен заявил, что новая версия бота — GPT-5 — достигнет уровня AGI, то есть сравняется по интеллектуальным возможностям с человеком. Релиз программы ожидается в декабре 2023-го.

Преступное пренебрежение

"Я боюсь AGI, — признался Аррам Сабети, инвестор из Силиконовой долины. — Сбивает с толку, что люди настолько пренебрежительно относятся к рискам".

В соцсетях он рассказал, что дружит с десятками специалистов — разработчиков систем искусственного интеллекта и "почти все они обеспокоены".

"Представьте себе строительство нового типа ядерного реактора, который будет производить бесплатную энергию, — поясняет Сабети. — Люди взволнованы, но половина инженеров-ядерщиков считает, что существует по крайней мере десятипроцентная вероятность "чрезвычайно серьезной" катастрофы, а инженеры по технике безопасности оценивают ее более чем в 30 процентов. Именно такова ситуация с AGI".

Один из опросов, на которые ссылается Сабети, показал: почти половина из 738 специалистов по машинному обучению дали не менее десяти процентов вероятности "крайне плохого исхода" в результате развития ИИ.

Другое исследование, в котором опросили 44 экспертов в области безопасности искусственного интеллекта, дало 30-процентную вероятность киберапокалипсиса, причем отдельные специалисты оценили ее выше 50 процентов.

Сабети отметил, что шанс проиграть в русскую рулетку — всего 17 процентов. И вспомнил давнее высказывание Илона Маска: "ИИ намного опаснее ядерного оружия".

"Рванет? Не должно"

Российские эксперты в области IT-технологий неоднозначно оценивают возможность перехода существующих систем ИИ на новый, "самостоятельный" уровень. По мнению некоторых, предотвратить это уже нельзя.

"В интернете есть одно замечательное правило: если что-то туда попадает, то остается навсегда. В истории множество примеров, когда прогресс пытались остановить, но ни разу это не приводило к успеху", — говорит эксперт по искусственному интеллекту и машинному обучению, преподаватель Московской школы программистов (МШП) Василий Лысов.

Другие специалисты считают, что технологической основы для такого перехода пока не существует. Чтобы перерасти в сильный ИИ, система должна научиться изменять свой первичный код.

"Именно так делают люди, постоянно переписывая нейронные связи в мозге. ИИ придется запросить модификацию своего кода у разработчика либо найти способ обойти этот барьер и выполнить модификацию самостоятельно. При этом он должен обладать достаточным уровнем мышления, чтобы не допустить ошибку в переписывании кода и, например, не заблокировать себя. Пока мы далеки от создания такого интеллекта", — уверен Макеев.

Наконец, некоторые эксперты отмечают, что даже с самим понятием "общего ИИ" не все однозначно. "Сперва нужно прийти к общему пониманию, что же такое AGI и точно ли он достижим. Однозначных критериев пока нет. Мы до сих пор не до конца понимаем, как работает память, мышление и многие другие биологические процессы", — объясняет руководитель группы группы машинного обучения Positive Technologies Александра Мурзина.

По ее словам, мы "и близки к цели, и одновременно далеки от нее". "Развитие технологий нелинейно, и трудно предсказать, когда будет следующий прорыв, чтобы приблизиться к AGI", — считает она.

"Можно договориться"

Если предотвратить появление AGI не удастся, то ограничить его технологические возможности — более чем реально, полагают специалисты.

"Для обучения нейросетей нужны совершенно конкретные вычислительные мощности, наборы данных. Без доступа к технологической инфраструктуре, "на коленке", никакие системы, угрожающие человечеству, создать нельзя. Бигтехов в мире не так и много, вполне можно договориться об ограничениях, тем более на государственном уровне", — говорит декан факультета "Цифровая экономика и массовые коммуникации" МТУСИ Сергей Гатауллин.

По мнению экспертов, людям не о чем беспокоиться, пока они контролируют материальный мир.

"Любое ИИ-решение — это программный код, который запускает аппаратное обеспечение: физически существующие сервера, мощные компьютеры. У аппаратного обеспечения есть кнопка выключения. У программы нет возможности нажать ее самостоятельно. А сценарий, при котором роботы на базе ИИ будут мешать человеку нажать на эту кнопку, сейчас нельзя реализовать из-за слабого развития робототехники", — указывает профессор Зараменских.

Правда, в теории ИИ сможет обойти это ограничение, превратившись в децентрализованную систему на пользовательских устройствах — то есть, на наших ноутбуках или смартфонах.

"Но крупные компании-производители смартфонов и ноутбуков имеют возможность удаленно заблокировать устройства — в этом случае даже децентрализованный ИИ быстро потеряет существенную часть вычислительных мощностей", — убежден эксперт.

Для контроля над AGI рассматривают несколько подходов. Помимо ограничения доступа к физическим ресурсам человечество может противопоставить независимому ИИ "дружественную" нам систему, в основе которой будут лежать этические и социальные нормы и ограничения, говорит старший инженер по работе с данными "Лаборатории Касперского" Альфия Латыпова.

"Многие исследователи и организации разрабатывают стандарты и нормативы, которые могут помочь регулировать создание и использование AGI, — отмечает она. — Это может включать международные соглашения, регулирующие производство и использование AGI, а также документы, определяющие поведение ИИ в таких областях, как медицина, автономная техника и промышленность".

"С пониманием к людям"

Российские эксперты считают маловероятной возможность экзистенциальной угрозы человечеству со стороны ИИ. Для уничтожения нашего вида искусственному интеллекту понадобилось бы создать "индустриальную пирамиду", получив доступ к металлам, электричеству, нефти и другим ресурсам. А для этого необходимо полностью исключить людей из производственных цепочек.

"Но мировая промышленность все еще в значительной степени зависит от ручного труда. Перед тем как ИИ сможет истребить человечество, нашему виду нужно произвести полную автоматизацию производства и функционирования всего на свете. В обозримой перспективе это не выглядит реалистичным", — рассуждает директор по развитию компании по разработке ПО "Формат Кода" Александр Жуков.

И тем не менее независимый синтетический разум способен нанести людям существенный вред.

"Представьте, что он контролирует информационную повестку разных регионов мира и провоцирует конфликты, манипулируя фактами. Если эти факты частично основаны на реальных данных, некоторые люди им поверят — и последствия будут непредсказуемы", — предупреждает Александр Кобозев, директор направления Data fusion Лиги цифровой экономики.

Мурзина полагает, что AGI, возможно, не главная угроза человечеству. Люди по-прежнему сталкиваются с новыми вирусами, военными конфликтами и техногенными катастрофами. "Точно ли AGI успеет появиться и навредить раньше, чем другие риски?" — задается вопросом эксперт.

Другие специалисты настроены оптимистично. "На мой взгляд, общий искусственный интеллект, или суперинтеллект, будет достаточно разумен, чтобы осознать, почему его собрали и обучили", — говорит Макеев.

По его мнению, ИИ учтет слабости своих создателей и поэтому "с пониманием отнесется к людям".